정보관리기술사/AI

활성화 함수(activation function)

기술기술

2024. 1. 30. 10:57

1. 정의

- 신경망 학습 모델의 input 값에서 output값을 도출할때, 임계치(threshold, Critical Point) 내에서 output 이 도출되도록 transfer 하는 함수

2. 활성화 함수 종류 - 단경시렐소 양항탄엘 계

| 구분 | 명칭 | 그래프 | 설명 |

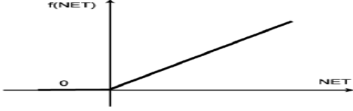

| 단극성 | 경사함수 |  |

- 단극성 선형 연속 함수 |

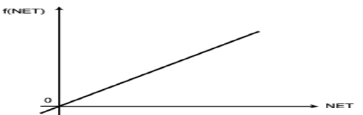

| Sigmoid |  |

- 로지스틱 함수, x값을 변화에 따라 0~ 출력 | |

| ReLU(Rectified Linear Unit) |  |

- x값이 음수일 땐 0 고정 - 기울기 소실 문제 발생 - 시그모이드보다 6배 빠름 |

|

| Softmax | 2차원 그래프 표현 불가 | - 여러 입력값을 0~1로 나눠어 표현 - 마지막 출력층에서 결과값을 분리(SVM 유사) |

|

| 양극성 | 항등함수 |  |

- 양극성 선형 연속 함수 - 입력의 가중합 출력 |

| tanh |  |

- 시그모이드보다 기울기가 크며 -1~1 범위를 가짐 | |

| LReLU(Leaky ReLU) |  |

- 음수일 때 입력값의 1/10 출력 - 기울기 소실 문제 해결 |

|

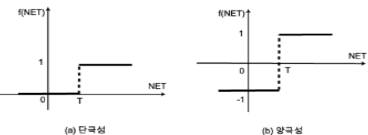

| 단극 or 양극성 | 계단함수 |  |

- 단극성 또는 양극성 이진함수 - 디지털 형태 출력 요구에 사용 |