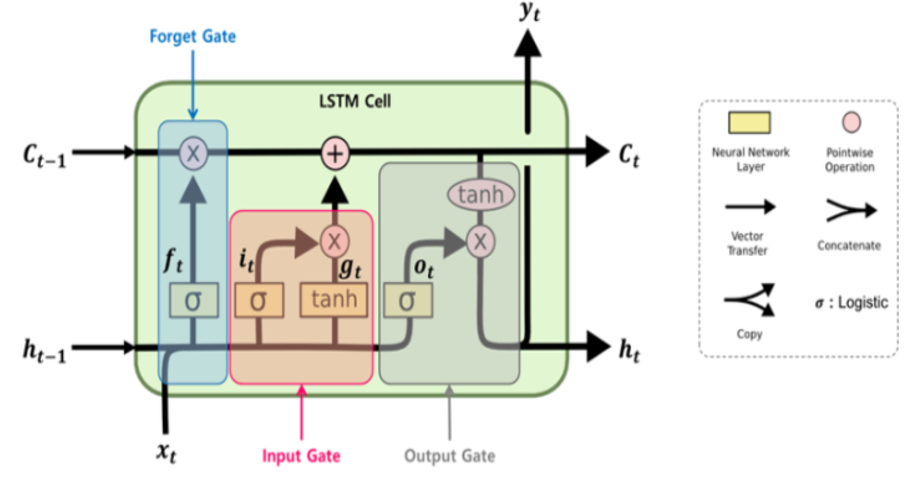

1. 정의 LSTM의 은닉 상태를 업데이트하는 계산을 줄인 장단기 메모리 순환 신경망 LSTM의 장기 의존성 문제에 대한 해결책을 유지하면서, 은닉 상태를 업데이트하는 계산을 줄임 성능은 LSTM과 유사하면서 복잡했던 LSTM의 구조를 간단화 데이터 양이 적을 때는 매개 변수의 양이 적은 GRU가 조금 더 낫고, 데이터 양이 더 많으면 LSTM이 더 나음 2. 구성도 및 구성요소 가. 구성도 - 화살표 좌중우위위, 시시탄 X1-XX+ 나. 구성요소 - 리업캔히